· Nolwen Brosson · Blog · 6 min read

Comprendre l’IA en 2025 : du grand modèle de language à l’automatisation no code

Le paysage de l’IA avant la révolution des LLM

Avant 2022, l’intelligence artificielle faisait déjà partie de notre quotidien, mais plus subtilement. Elle se manifestait à travers des algorithmes de recommandation sur des apps comme Instagram, Amazon, ou dans des outils de traduction comme Deepl. Ces systèmes fonctionnaient trés bien, mais étaient spécialisés: chaque IA était conçue pour une seule tâche précise, comme la reconnaissance d’images.

Ces outils manquaient de flexibilité et avaient souvent peu de capacité conversationnelle. Le paysage de l’IA était une collection d’outils performants mais cloisonnés, chacun opérant en silo.

Le tournant : l’avènement des grands modèles de langage (LLM) généralistes

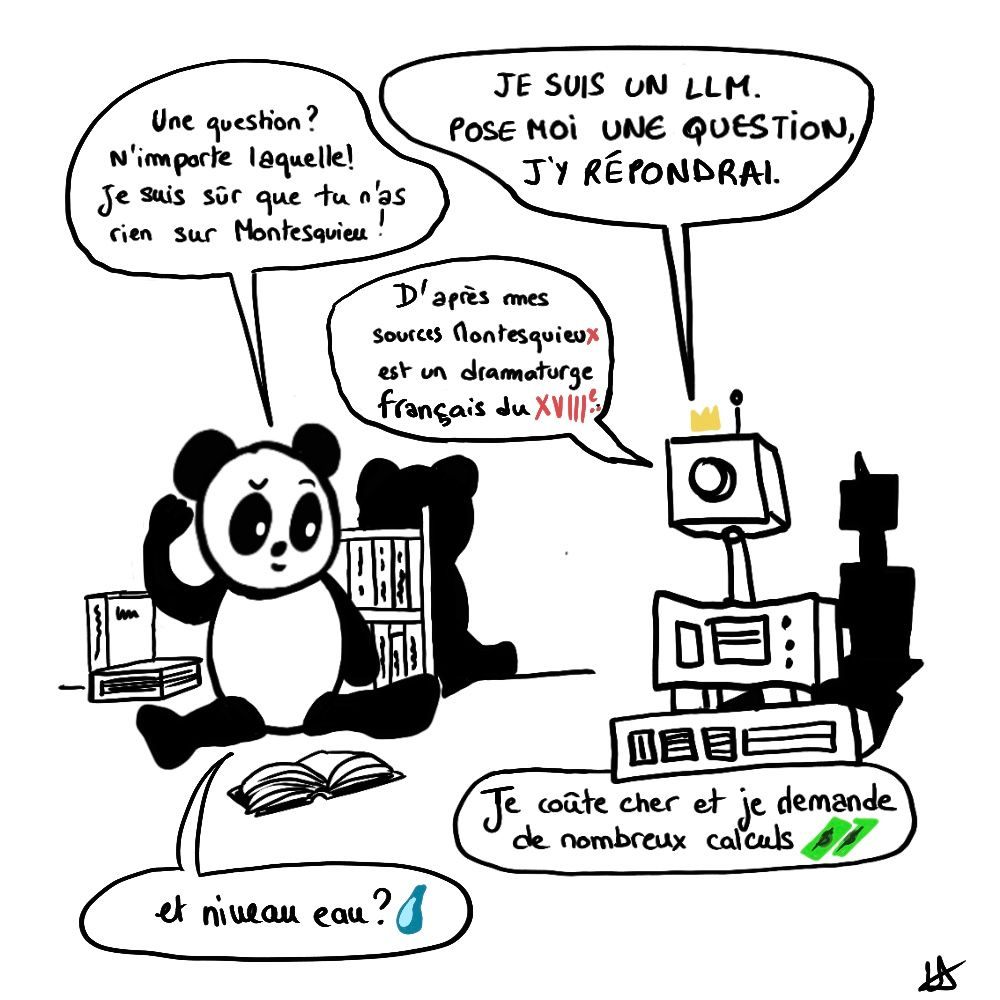

L’arrivée des grands modèles de langage, ou LLM, notamment chat GPT en novembre 2022 a bouleversé tout ça. Les LLMs sont un peu comme une version numérique de la Bibliothèque Nationale de France qui aurait non seulement lu tous les livres, mais qui serait aussi capable de les synthétiser. Grâce à ça, l’IA n’est plus perçu comme un outil monotâche, mais comme un véritable couteau suisse.

L’IA n’est plus un concept abstrait réservé aux experts, mais un outil conversationnel accessible à tous, capable de rédiger des emails, de générer du code ou de résumer des documents complexes. Pourtant, ces modèles généralistes ne sont pas parfaits:

- Ils souffrent de ce que l’on appelle des « hallucinations », produisant des informations qui semblent plausibles mais qui sont en réalité incorrectes.

- De plus, leur fonctionnement nécessitent une puissance de calcul considérable, ce qui représente un coût élevé et un obstacle pour une adoption à grande échelle

Spécialisation et efficacité : fine-tuning, RAG et SLM

Face aux limites de ces modèles généralistes, la tendance s’est rapidement orientée vers la spécialisation. C’est ici qu’intervient le fine-tuning. Le concept est simple : on prend un modèle généraliste et on l’entraîne sur un ensemble de données très ciblées pour en faire un expert de ce domaine. Par exemple, on pourrait imaginer qu’une boîte comme Doctolib donne une grosse quantité de questions & réponses liées à la santé, afin de produire un modèle spécialisé dans l’accompagnement des médecins pour faciliter leur quotidien. Pour aller plus loin sur le fine-tuning, il y a ce super papier de recherche: https://arxiv.org/html/2408.13296v1 (une bonne partie est trés abordable).

Cependant, le fine-tuning présente un inconvénient majeur : il est coûteux et techniquement complexe. C’est pour cette raison qu’une approche alternative s’est largement démocratisée : le RAG (Retrieval-Augmented Generation). Plutôt que de réentraîner un modèle généraliste, on le connecte à une base de connaissances externe, que le modèle peut interroger en temps réel. Cela permet d’obtenir des réponses précises et actualisées sans modifier le modèle lui-même. Un chatbot pour votre site web est un use case parfait pour cette technique. Mais attention, plus la base de connaissance est volumineuse ou mal structurée, plus le modèle généraliste aura du mal à utiliser correctement l’information. C’est un problème trés fréquent. AWS explique bien le fonctionnement de RAG ici: https://aws.amazon.com/fr/what-is/retrieval-augmented-generation/ .

Enfin, il est également possible de concevoir des modèles plus légers et conçus pour l’efficacité: les Small Language Models (SLM). Ils ne possèdent pas l’étendue des connaissances d’un LLM, mais ils excellent dans des tâches précises tout en consommant beaucoup moins de ressources. Leur faible coût et leur rapidité les rendent parfaits pour des applications directement sur nos appareils, comme un smartphone, et garantissent une meilleure confidentialité des données puisqu’elles ne vont pas par le cloud.

L’essor des agents IA autonomes

Après la capacité à comprendre et à générer du texte, l’étape suivante a été de donner à l’IA la capacité d’agir. C’est le rôle des agents IA. La différence avec un simple chatbot est fondamentale. Un agent IA peut planifier puis executer: il peut réserver les billets de train, envoyer des emails et interagir avec d’autres applications. Des frameworks comme LangChain ou CrewAI peuvent aider à construire ces agents.

La démocratisation de l’IA avec l’automatisation no-code

L’un des changements les plus significatifs de l’IA en 2025 est sans doute sa démocratisation. Grâce à l’automatisation workflow no-code, il n’est plus nécessaire d’être développeur pour créer des processus intelligents. Des plateformes comme Zapier, make.com ou l’alternative open-source n8n permettent ainsi de connecter des modèles d’IA à nos applications du quotidien, comme Gmail, Slack ou Google Sheets.

Concrètement, n’importe qui peut désormais construire un flux de travail qui:

- récupère les emails d’une boite mail

- y applique quelques modifications

- Transfère le mail modifié à un autre destinataire

Cette accessibilité change la donne, en particulier pour les entreprises sans équipes de R&D, qui peuvent maintenant tirer parti de ces technologies sans dépenser des centaines de milliers d’euros.

Conclusion : l’IA devient architecte

En 2025, l’IA bascule vers un rôle d’orchestrateur. Vous ne vous contentez plus d’un modèle: vous créez un environnement dans lequel ce modèle se déploie, interagit et s’intègre à vos process.

Le récent travail réalisé par l’équipe de Meta FAIR en septembre 2025: “CWM: An Open-Weights LLM for Research on Code generation with World Models” illustre ce tournant : plutôt que de simplement apprendre à prédire du code, ce modèle a été entraîné à modéliser un environnement, des actions, des effets. L’IA ne se contente plus de « voir » le code, elle « imagine » ce qu’il va faire, comment il va évoluer dans un système, un saut qualitatif majeur.

Pour nous, la question n’est plus « quel modèle » mais « quel écosystème d’IA vais-je bâtir » :

- Comment je choisis entre un modèle généraliste ou un modèle spécialisé?

- Comment je lie ce modèle à mes données ou workflows no-code?

- Comment je conçois l’agent qui va déclencher les actions, ajuster les résultats, apprendre de mes retours ?

- Et bien-sûr : comment je mets cela en place avant mes concurrents?

Ce que montre CWM, c’est que les prochaines étapes de l’IA seront moins dans l’« augmentation » (ajouter plus de taille, plus de paramètres) que dans l’« intégration » : du modèle à l’agent, de l’agent au processus, du processus à l’entreprise. Vous passez d’un modèle qui répond à des requêtes à un agent qui anticipe des besoins, déclenche des actions, synchronise des systèmes.